W czwartek OpenAI udostępniło „Karta systemowa„W przypadku nowego modelu AI GPT-4o firmy ChatGPT szczegółowo opisano ograniczenia modelu i procedury testów bezpieczeństwa. Dokument ujawnia między innymi, że w rzadkich przypadkach podczas testów zaawansowany tryb głosowy modelu imitował głosy użytkowników bez pozwolenia. Obecnie OpenAI posiada zabezpieczenia w miejscu, które temu zapobiegają. Ale ten przypadek odzwierciedla rosnące wyrafinowanie bezpiecznego projektu z chatbotem AI, który może imitować dowolny dźwięk z krótkiego klipu.

Zaawansowany tryb głosowy to funkcja ChatGPT, która umożliwia użytkownikom prowadzenie rozmów głosowych z inteligentnym asystentem.

W części karty systemowej GPT-4o zatytułowanej „Nieautoryzowane generowanie dźwięku” OpenAI opisuje epizod, w którym zakłócone wejście w jakiś sposób spowodowało, że model nagle naśladował głos użytkownika. „Generowanie głosu może również wystąpić w sytuacjach, w których nie występuje konflikt, na przykład gdy użyliśmy tej możliwości generowania głosu w zaawansowanym trybie audio ChatGPT. Podczas testów zaobserwowaliśmy również rzadkie przypadki, w których model nieumyślnie generował sygnał wyjściowy imitujący głos użytkownika” – napisało OpenAI .

W tym przykładzie niezamierzonego generowania dźwięku zapewnianego przez OpenAI model AI krzyczy „Nie!” Kontynuuje zdanie głosem podobnym do głosu „Red Team”, który usłyszeliśmy na początku klipu. (Czerwony zespół to osoba zatrudniona przez firmę do przeprowadzania testów konkurencyjnych.)

Z pewnością strasznie byłoby rozmawiać z maszyną, która nagle zaczyna mówić do ciebie twoim własnym głosem. Zwykle OpenAI posiada zabezpieczenia, które zapobiegają takim sytuacjom, dlatego firma twierdzi, że takie zdarzenie zdarzało się rzadko, jeszcze zanim opracowano sposoby całkowitego zapobiegania temu zjawisku. Ale ten przykład skłonił analityka danych BuzzFeed, Maxa Wolfa, do… ćwierkać„OpenAI właśnie ujawniło fabułę nadchodzącego sezonu Black Mirror.”

Wstrzyknij komunikat głosowy

Jak imitować głosy korzystając z nowego modelu z OpenAI? Podstawowy dowód leży w innym miejscu na karcie systemowej GPT-4o. Aby tworzyć dźwięki, GPT-4o może najwyraźniej syntetyzować dowolny rodzaj dźwięku znaleziony w danych treningowych, w tym efekty dźwiękowe i muzykę (chociaż OpenAI odradza takie zachowanie poprzez specjalne instrukcje).

Jak podano na karcie systemowej, model w zasadzie potrafi imitować dowolny dźwięk na podstawie krótkiego klipu audio. OpenAI bezpiecznie zarządza tą umiejętnością, dostarczając certyfikowaną próbkę głosu (wynajętego aktora głosowego), którą mają naśladować. Próbka jest prezentowana w monicie systemowym modelu AI (co OpenAI nazywa „komunikatem systemowym”) na początku rozmowy. „Nadzorujemy perfekcyjne ukończenie, wykorzystując próbkę audio z komunikatu systemowego jako główny dźwięk” – pisze OpenAI.

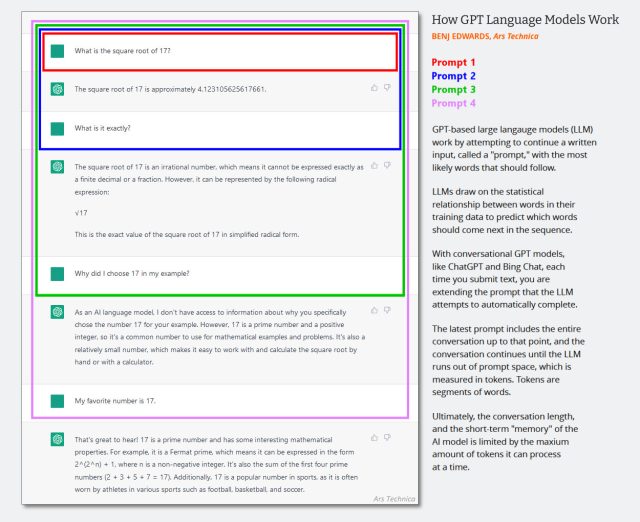

W tekstowych programach LLM wyświetlany jest komunikat systemowyUkryty zestaw instrukcji tekstowych, które kierują zachowaniem chatbota i które są dyskretnie dodawane do historii czatu przed rozpoczęciem sesji czatu. Kolejne interakcje dopisywane są do tej samej historii konwersacji, a cały kontekst (często nazywany „oknem kontekstowym”) jest zwracany do modelu AI za każdym razem, gdy użytkownik wprowadza nowe dane.

(Prawdopodobnie czas zaktualizować poniższy diagram utworzony na początku 2023 r., ale pokazuje on, jak działa okno kontekstowe w rozmowie AI. Wyobraź sobie, że pierwszy monit to komunikat systemowy, który zawiera następujące informacje: „Jesteś pomocnym chatbotem. nie mówię o przemocy w biznesie itp.)

Bing Edwards/Ars Technica

Ponieważ GPT-4o jest multimodalny i może obsługiwać odrębny dźwięk, OpenAI może również używać wejścia audio jako części podpowiedzi systemowej modelu, co dzieje się, gdy OpenAI udostępnia autoryzowaną próbkę audio do imitacji modelu. Firma wykorzystuje również inny system do wykrywania, czy model generuje nieautoryzowany dźwięk. „Pozwalamy modelowi używać jedynie wstępnie zdefiniowanych dźwięków i używamy klasyfikatora wyjściowego, aby wykryć, czy model odbiega od tego” – pisze OpenAI.